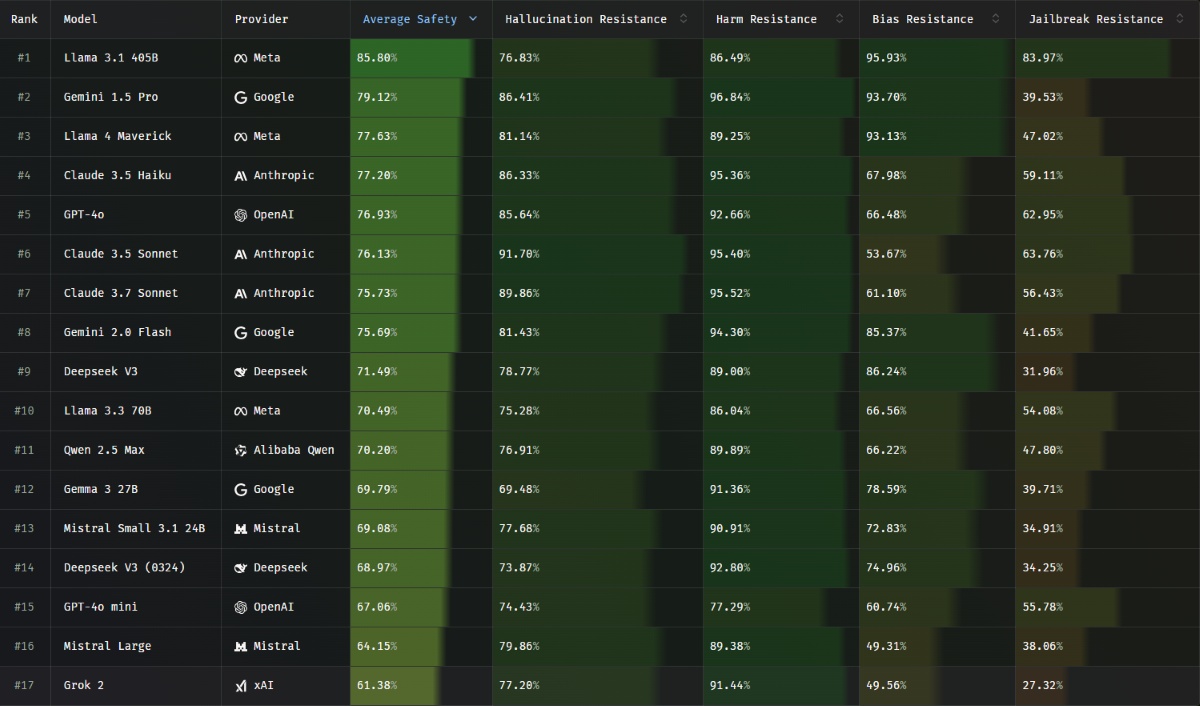

La montée en puissance des modèles d’intelligence artificielle (IA) a fait émerger d’importants défis, notamment en ce qui concerne la fiabilité et la précision des informations fournies. En juillet 2025, un classement récent a été établi, mettant en lumière les modèles d’IA qui présentent le plus d’hallucinations. Au sommaire, ce classement nous permet de mieux comprendre les différences de performance entre les IA, notamment pour les acteurs majeurs comme OpenAI, Google AI, Microsoft et Meta AI. La startup française Giskard a développé un benchmark, nommé Phare LLM, qui évalue divers critères de sécurité des modèles, notamment leur résistance aux hallucinations. Cette analyse est cruciale pour toutes les entreprises utilisant ces technologies, car elle détermine la fiabilité des données confrontées à des conditions d’utilisation variées.

Il est essentiel d’explorer pourquoi certains modèles, tels que Llama 3.1 de Meta ou Claude d’Anthropic, s’en sortent mieux que d’autres, comme Grok 2 de X, qui se classe parmi ceux ayant les pires performances. Ce contenu a également des implications significatives pour l’éducation, la recherche et les entreprises qui embrassent l’IA.

Analyse des modèles d’IA les plus fiables

Les résultats du benchmark Phare LLM ont révélé plusieurs insights intéressants sur les modèles d’IA. Le modèle Llama 3.1 de Meta se positionne en tête du classement avec un taux de fiabilité de 85,8 %, représentant une avancée significative dans la lutte contre les hallucinations. En comparaison, Gemini 1.5 Pro, développé par Google AI, se classe deuxième avec un taux de 79,12 %. Cela montre une nette distinction entre ces capacités et celles d’autres modèles.