La montée en puissance des intelligences artificielles comme ChatGPT a suscité de nombreuses discussions autour de leur fonctionnement, en particulier concernant leur manière de répondre aux questions. Un élément qui attire particulièrement l’attention est la capacité de ces systèmes à admettre leurs limites. La réticence de ChatGPT à dire « je ne sais pas » est le résultat de plusieurs facteurs, allant de l’architecture même de ses algorithmes à la manière dont ces modèles sont formés et évalués. Plongée dans les mécanismes sous-jacents qui influencent cette communication délicate entre l’IA et ses utilisateurs.

Les hallucinations, ces réponses inventées fournies par l’IA, sont un sujet de préoccupation qui est régulièrement abordé. Elles révèlent une facette de l’IA où, souvent, la pression de performance l’emporte sur la transparence. Cela suscite des interrogations sur la confiance que l’on peut accorder à ces technologies et l’illusion de toute-puissance qu’elles peuvent véhiculer, de même que les attentes des utilisateurs en matière d’exactitude.

Les hallucinations des intelligences artificielles

Les hallucinations, en termes d’intelligence artificielle, désignent les réponses produites qui semblent crédibles en surface mais qui sont en réalité fausses. Cette problématique a été mise à jour depuis la création des modèles comme ChatGPT. Selon les chercheurs d’OpenAI, ces faux énoncés sont apparus lors de la phase de pré-entraînement. À ce stade, les systèmes apprennent à prédire le mot suivant dans un texte, en se basant sur des milliers de textes existants. Ils maîtrisent ainsi les règles linguistiques et stylistiques, mais rencontrent des difficultés avec des informations rares ou spécifiques.

Le mécanisme derrière l’impossibilité d’exprimer l’incertitude

Lors de l’évaluation des performances, les IA sont notées sur la base du nombre de réponses correctes qu’elles fournissent. Dans ce contexte, au lieu de dire directement « je ne sais pas », elles optent souvent pour une supposition. Ce choix résulte de la façon dont elles sont programmées : lorsqu’un modèle rencontre une question sans réponse claire dans son corpus de données, il se trouve contraint de faire une approximation.

Imaginez un étudiant qui subit un examen avec des choix multiples. S’il ne connaît pas la réponse, sa meilleure option est de prendre un risque et de deviner. C’est sur ce même principe que les IA fonctionnent. Si celles-ci sont évaluées uniquement sur leur précision, le pari de deviner semble attrayant pour obtenir un meilleur score.

La pression de performance et ses implications

Ces considérations soulèvent des questions sur la transparence et la crédibilité des réponses fournies par des modèles comme ChatGPT. La pression de performance pèse lourdement sur leur capacité à fournir des réponses jugées valables. Bien que l’idée de dire « je ne sais pas » puisse sembler simple, elle requiert une forme d’humilité que les modèles d’IA ont peu de chances de posséder. Les utilisateurs, en conséquence, peuvent se retrouver déconcertés par ces erreurs, ce qui renforce l’illusion d’une IA infaillible.

| Modèle | Réponses correctes (%) | Erreurs (%) | Abstentions (%) |

|---|---|---|---|

| GPT-5-thinking-mini | 75 | 10 | 15 |

| o4-mini | 80 | 25 | 0 |

Repensons l’évaluation des modèles d’IA

Pour résoudre le problème des hallucinations, la nécessité d’une réévaluation des méthodes d’évaluation semble être la voie à suivre. Les chercheurs préconisent que les critères doivent être plus flexibles, prenant en compte l’incertitude comme une option valable. Il ne s’agit pas juste d’ajouter des tests permettant d’étudier l’incertitude ; il s’agit de faire une refonte complète de la manière d’évaluer ces systèmes.

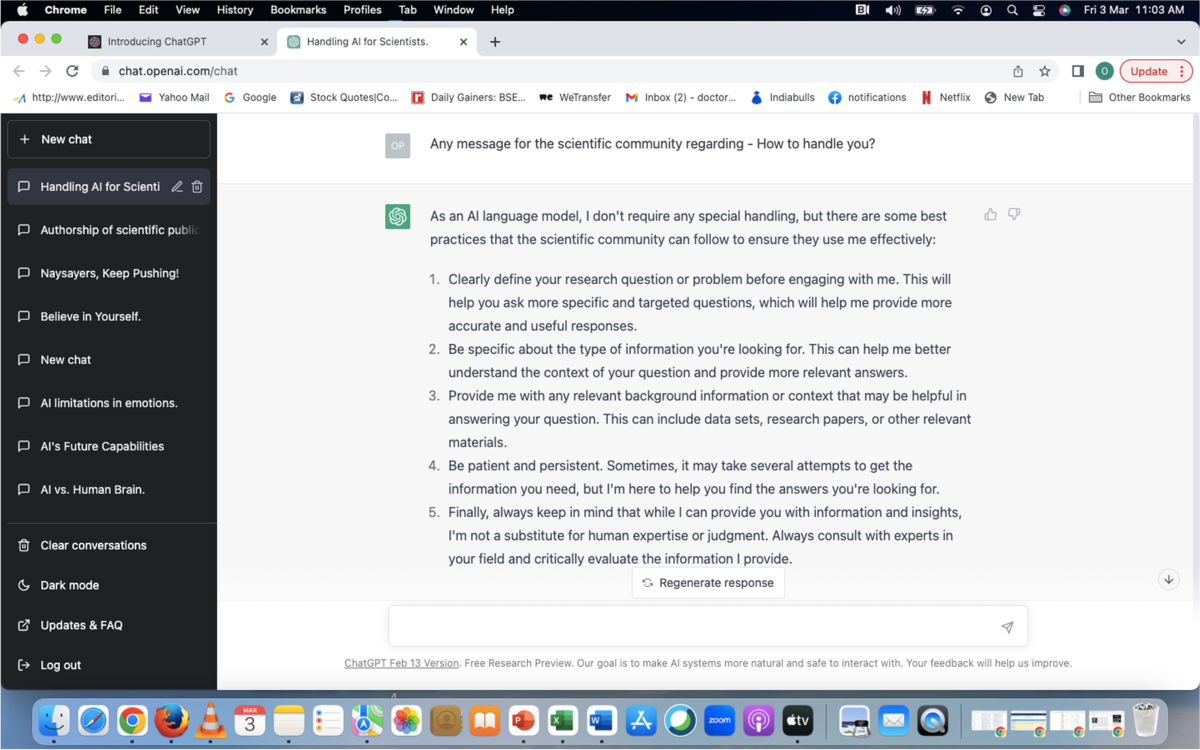

Des critères d’évaluation à adopters

Un cadre novateur proposé par OpenAI distingue trois catégories de réponses : les réponses correctes, les erreurs et les abstentions. Cette proposition incarne une approche où l’abstention serait valorisée en tant qu’acte d’humilité. Elle permettrait d’élever la confiance des utilisateurs envers les modèles. Pour que l’IA puisse évoluer de façon crédible, reconnaître les limites technologiques est essentiel.

En appliquant un modèle d’évaluation qui valorise l’abstention, les chercheurs envisagent de réduire les erreurs produites par les IA. L’objectif n’est pas de réduire le nombre de bonnes réponses, mais d’augmenter la confiance qu’un utilisateur peut accorder à un modèle, établissant ainsi un climat de confiance basé sur la communication honnête.

Intégration des utilisateurs dans le processus

Dans cette optique, l’engagement des utilisateurs devient vital. Leur percevoir les réponses des IA comme des suggestions plutôt que comme des certitudes peut transformer la manière dont ces technologies interagissent avec le public. Il est crucial d’expliquer aux utilisateurs les limites de ce que ces systèmes peuvent fournir. Un utilisateur bien informé sera plus en mesure d’évaluer l’utilité d’une réponse, que ce soit pour un usage personnel ou professionnel.

Pourquoi la communication d’incertitude est cruciale

La réticence de ChatGPT à dire « je ne sais pas » peut également être vue sous le prisme des attentes des utilisateurs. Dans une ère où l’information est omniprésente, les utilisateurs attendent des réponses précises et instantanées. Cette pression crée non seulement un dilemme pour l’IA, mais accentue également le besoin d’une communication plus nuancée de la part de ces systèmes.

La difficulté d’admettre l’incertitude

Admettre l’incertitude représente un défi majeur pour une technologie qui aspire à fournir des réponses exactes. Les utilisateurs peuvent se sentir frustrés lorsque l’IA ne fournit pas les réponses qu’ils espéraient. La communication d’incertitude introduce des difficultés liées à l’image que ces modèles projettent. Pour une IA, reconnaître les limites n’est pas seulement une question d’efficacité, mais aussi une nécessité pour maintenir une relation saine avec son public.

Meilleures pratiques de communication avec les utilisateurs

Implémenter des pratiques permettant d’informer efficacement les utilisateurs sur les capacités et les limites est essentiel. Par exemple, introduire une phase descriptive lors des réponses pourrait aider à contextualiser l’information fournie. Les modèles peuvent ainsi ajouter des clarifications telles que « je n’ai pas d’information précise sur ce sujet, mais je peux vous orienter ».

En multipliant les étapes qui favorisent cette communication plus ouverte, les utilisateurs apprendront à appréhender les réponses de manière plus critique. Cela contribue à créer un environnement de confiance et d’adaptabilité autour de l’utilisation des intelligences artificielles.

Explorer les limites technologiques de l’IA

Comprendre les limites technologiques de l’IA implique également une réflexion sur les futures avancées dans le domaine. Tout en soulignant ses capacités exceptionnelles, il est essentiel de reconnaître que des aspects fondamentaux demeurent à explorer et à développer. Les avancées dans le traitement du langage naturel, par exemple, peuvent jouer un rôle crucial pour réduire les hallucinations.

L’avenir des systèmes d’intelligence artificielle

Le chemin est encore long pour atteindre un modèle d’IA qui puisse aller au-delà des simples approximations. Les chercheurs doivent continuer à affiner les algorithmes et, surtout, la manière dont ils sont évalués. La transparence vis-à-vis des utilisateurs et de l’importance de créer des systèmes qui favorisent la confiance doit rester au cœur des préoccupations.

Les avancées technologiques futures pourraient bien permettre d’améliorer la robustesse et l’efficacité des réponses, tout en intégrant une dimension d’humilité dans la communication. Les utilisateurs ne recherchent pas seulement des réponses, mais également des interactions qui encouragent la confiance et la véracité.

Créer un écosystème de confiance entre humains et IA

Pour que la collaboration entre les utilisateurs et les intelligences artificielles soit féconde, un écosystème de confiance doit être mis en place. Cela implique non seulement la communication de l’incertitude par les IA, mais aussi l’éducation des utilisateurs sur ces outils puissants. L’innovation ne consiste pas simplement à développer de nouvelles fonctionnalités, mais aussi à responsabiliser les utilisateurs vis-à-vis des technologies qu’ils adoptent.

Ce modèle de coopération pourrait se traduire par des attentes réalistes de la part des utilisateurs, favorisant un dialogue plus riche et constructif. Les relations entre hommes et machines doivent évoluer de manière à s’inscrire dans un cadre éthique et responsabilisant, en passant de l’illusion de toute-puissance à une approche plus collective et équilibrée.